静電容量式タッチインターフェースが急速に普及し、従来のメカニカルキーのような限定的な機能しか持たない製品が続々と置き換えられています。タッチ操作やスワイプ動作のおかげで、ユーザーフレンドリーなタッチパネルを使うこと、さらに複雑で高度な操作が必要な機器のコントロールもできるようになっています。指先の動きやハンドジェスチャーでタスクを実行することが、ついに現実のものとなったのです。人間の自然なコミュニケーション方法のひとつであるジェスチャーが、スマートエンド製品の操作に用いられるのは至極当然な結果と言えます。マイクロコントローラやマイクロプロセッサーなどの組込み機器の発展にエンドポイントでの統合が相まって、インテリジェントなセンサー駆動ジェスチャー認識が実現しているのです。

さらに一般的なスマートフォンのみならず、より頑健で安全性が重要な産業用アプリケーションにまでその用途は広がっています。高機能な機械学習を自動化できるAutoMLや、その他の組み込み型 AI/ML ツールも、タッチベースのドラッグ&ドロップ分析に移行しています。指の力を感知するだけで何がしたいのか理解できる、インテリジェントなタッチスクリーンがあることは非常に便利なのです。

人間とコンピュータのコミュニケーション向上のために設計されているジェスチャー認識プロセスは、タッチスクリーン、カメラ、周辺機器などさまざまなツールを通して行われます。直接タッチせずに操作できる、タッチレスユーザーインターフェース(TUI)ベースのアプリケーションの一部でもあるのです。ビジョンベースの認識技術では、カメラとモーションセンサーを使用してユーザーの動きを追跡し、リアルタイムで変換していきます。デバイス搭載型モーションセンサーは、主な入力ソースとしてジェスチャーを追跡し、解釈します。触ること、切り替え、コントローラーを一切使わず、ヒューマンマシンインタラクション(HMI)のためにその手の動きを利用するのです。ヒューマンコンピュータインタラクションの観点から言うと、ジェスチャー制御システムは最も直感的で自然なものとなります。その進化は止まることはなく、ジェスチャーを捉えるために使われているセンサーに依拠します。ジェスチャー認識の最たる例として、AIバーチャルマウスが挙げられるでしょう。内蔵カメラやウェブカメラを通じて指先のジェスチャーを追跡し、マウスカーソル操作やスクロール機能を実行し、カーソルを一緒に動かします。ジェスチャーに従って仮想的に操作することができるのです。さらに、安全上重要でアクセスが困難な機器の統制や監視を行い、拡張現実やバーチャルリアリティ、手話認識、ゲームなどのユースケースに応用されていっています。

タッチレスなヒューマンマシンインタラクション(HMI)として、組み込み型ジェスチャー認識プロセスがあります。ヒューマンコンピュータインタラクションを向上させるために設計されており、タッチスクリーン、カメラ、周辺機器を使用します。現在、ジェスチャー認識とタッチ操作の両方が、ヒューマンコンピュータインタラクション(HCI)、もしくはモノのインターネット(IoT)の場合のヒューマンマシンインタラクションに使われています。

ヒューマンマシンインタラクションの中でも、ジェスチャー制御システムは最も直感的で自然なものと考えられています。ジェスチャーを捉えるセンサーの実験による改良をもとに、直感的なものからより信頼できるものへと発展してきました。

人工知能(AI)と機械学習は、リアルタイム分析時にスマートにタスクを実行し、ヒューマンマシンインタラクションによる最良の結果を提示します。その一方で、IoTはこれらのタスクを行うためのインフラを提供しています。AIは機械学習アルゴリズムによって意思決定の能力を提供し、IoTは接続性とデータ共有能力を提供しているのです。ネットワーク上のユーザーインタラクション、サービスプロバイダー、その他の関連デバイスに基づく学習など、AIとIoTの組み合わせによってより多くの機能を構築しているのです。

人工知能(AI)は、ジェスチャー認識やタッチ操作をサポートします。ユーザーが画面上で何を選択しようとしているか、アクション開始時に判断し、インタラクションを迅速化するのです。例えば、ドライビングシミュレーションの実験では、AIがホバー操作の開始時にユーザーの意図するターゲットを予測することで、最大50%の時間短縮と動力軽減を達成しました。さらに、ジェスチャーベースのIoTデバイスにおいても、AIによる精度の向上が可能であるとされています。

電磁およびRFノイズの問題に効果的に対処するためには、適切な組み込み型コンピュータデバイスの選択と、全体的なハードウェア設計がソリューションの鍵となります。重要事項である精度に対しては、適切なハードウェアを提供することで対応可能です。高度なカメラ、スマートウォッチ、ウェアラブルセンサー、またデータグローブは、ジェスチャーとタッチデバイスの一種であると同時に、テスト済みAIアルゴリズムの最良結果でもあります。そこでルネサスでは、多くのシーンでベストな選択となり得る、さまざまなタイプのハードウェアのセットを提供しております。

静電容量式タッチやジェスチャーによる操作が普及していく中で、正確で高度な操作性を実現するためには、パネルの感度や耐ノイズ性が重要なキーとなってきます。また、水や汚れ、温度変化などの環境耐性も避けられません。これらに加え、開発期間やコストなどの点も考慮する必要があります。

これらを受けてルネサスでは、第2世代の静電容量式タッチソリューションとして、機器や装置制御に特化した画期的なデザインを提案いたします。静電容量式タッチや3Dジェスチャー認識ソリューションの開発への参入障壁を低くする、ユーザーフレンドリーな環境をぜひご活用ください。

e-AI x 3Dジェスチャー認識 – ルネサスの普遍的ソリューション

ルネサスが提供する静電容量式タッチ用QEツール「3Dジェスチャー認識」機能は、組込みAIを利用したジェスチャーアプリケーションの開発をサポートします。AIアプリケーションの開発には複雑なステップを踏まなければなりませんが、ルネサスQEツールを使えば、組み込みエンジニアがAIの専門スキルを必要とせずにAIアプリケーションを開発することができます。

「3Dジェスチャー認識」でできること

高機能でインテリジェントなジェスチャーアプリケーション開発には、大きく以下の3つの機能が必要となります。

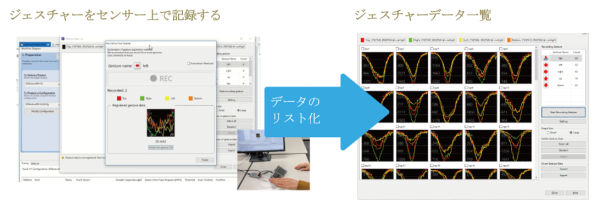

1. 記録する

AIに認識させたいジェスチャーを静電容量センサーに行い、ジェスチャーのデータを登録していきます。登録したデータは一覧で表示され、失敗したジェスチャーのデータ削除やインポート機能も存在します。

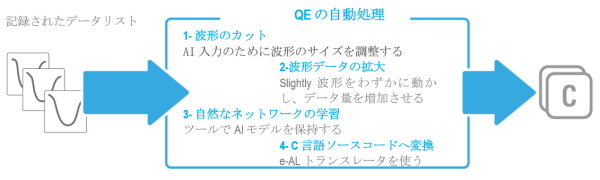

2. AIを作成する

AI(データの前処理、深層学習、C言語ソースコードへの変換)を作成する過程で、ルネサスQEツールは自動的にジェスチャーに最適な処理を施します。AI作成の自動化はたいがい困難ですが、ターゲットをジェスチャーに絞ることで実現可能となります。

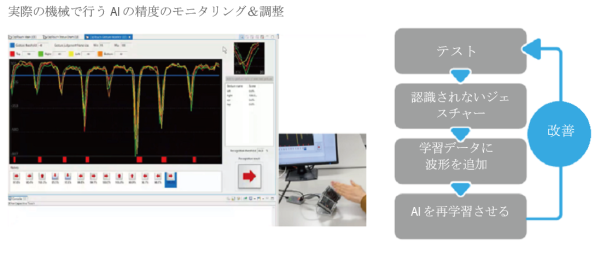

3. モニタリング&調整

作成したAIの精度は、実際の機械でモニタリングし調整できます。ジェスチャーが正しく認識されなかった場合、ルネサスのモニタリング画面で[データを追加する]ボタンをクリックし、すぐに学習データに波形を追加すると、AIアルゴリズムにフィードバックできます。

今後さらにジェスチャー認識の精度を高めるためには、解決しなければならない課題があります。莫大なデータ量や接触不良、視覚的に遮られた物体や照明の悪さなどが原因で、データの品質が低くなる問題などがその一例です。さらに、視覚データと感覚データ統合時はデータセットが不一致のため、別々に処理して最後に統合する必要があります。こういった事情はかなり非効率的で、応答が遅くなる原因となっています。

インテリジェントなタッチ操作およびスマートなジェスチャー認識ソリューションの需要は、消費者および産業分野での画期的なアプリケーションとともに増加傾向にあります。私たちの目の前に広がっている可能性は希望に満ち溢れているでしょう。詳細については、こちらのリンクをご覧ください。